개발 초급자의 시선 속 딥러닝과 파이토치

저는 몇 달 전까지만 해도 딥러닝이라는 단어조차 생소한 사람이었습니다. 인공지능이 점점 더 주목받고 있다는 이야기를 뉴스나 주변에서 듣기는 했지만, 솔직히 딥러닝과 머신러닝의 차이도 몰랐고, "파이토치(PyTorch)"라는 이름을 처음 들었을 때는 무슨 도구인지조차 상상할 수 없었죠. 하지만 막연하게나마 "이 기술은 앞으로 더 중요해질 거야"라는 생각이 들었고, 그래서 딥러닝 공부를 시작하기로 마음먹었습니다.

처음에는 단순히 흥미 위주로 시작했지만, 배우면 배울수록 딥러닝이 얼마나 넓고 깊은 분야인지 깨닫게 되었습니다. 특히 파이토치는 처음 접했을 때 어려웠지만, 사용하면 할수록 유연하고 강력한 도구라는 것을 알게 되어 매력적으로 다가왔습니다.

이번 12주차 과정에서는 딥러닝과 파이토치를 배우면서 겪었던 경험과 배운 내용을 단계적으로 정리해보고자 합니다. 딥러닝의 기본 개념부터 파이토치로 모델을 구현하고 고도화시키기까지, 초보자의 시선에서 시작해 실전까지 도전해본 저의 여정을 여러분과 나누고 싶습니다.

1. 딥러닝의 기본 개념: 발전과정과 핵심 기술

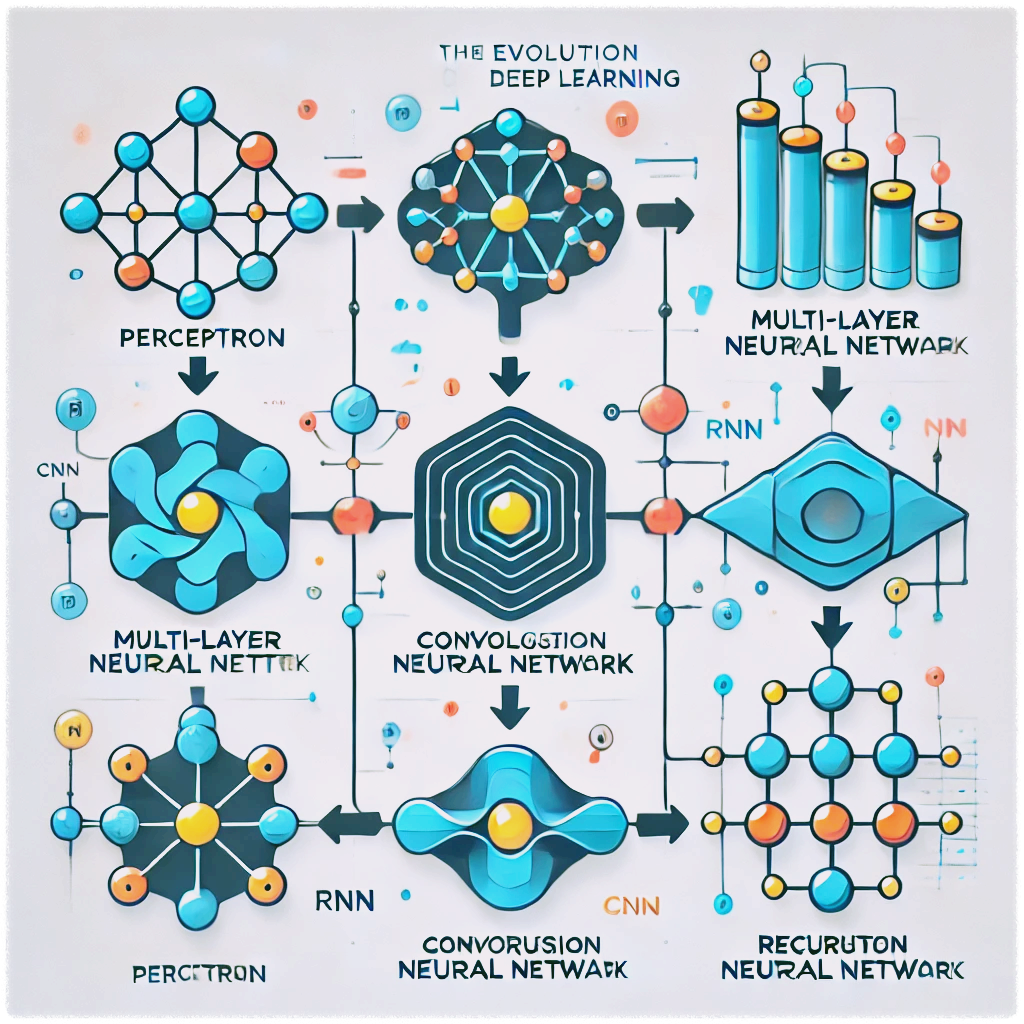

딥러닝은 데이터에서 패턴을 학습하고 복잡한 문제를 해결하는 인공지능의 한 분야로, 그 발전 과정에서 점점 더 복잡하고 강력한 모델들이 등장했습니다.

1950년대에는 가장 단순한 신경망 모델인 1단계 퍼셉트론(Perceptron)이 등장했습니다. 이 모델은 선형 분류 문제를 해결할 수 있었지만, 비선형 문제를 해결하지 못하는 한계가 있었습니다. 이후, 2단계 다층 퍼셉트론(Multi-Layer Perceptron, MLP)이 개발되면서 은닉층(Hidden Layer)을 추가하여 비선형 문제도 해결할 수 있게 되었습니다.

이미지 데이터 처리에 특화된 3단계 합성곱 신경망(Convolutional Neural Network, CNN)은 필터(커널)을 활용해 특징을 학습하는 모델로 발전했습니다. 이는 이미지 분류, 객체 탐지와 같은 다양한 컴퓨터 비전 작업에서 혁신을 가져왔습니다.

시퀀스 데이터(텍스트, 음성 등)를 다룰 수 있는 4단계 순환 신경망(Recurrent Neural Network, RNN)은 시간 순서에 따른 연속된 데이터를 학습할 수 있도록 설계되었습니다. 하지만, RNN은 긴 시퀀스 데이터 학습에 어려움이 있었고, 이를 개선하기 위해 LSTM(Long Short-Term Memory)과 GRU(Gated Recurrent Unit)와 같은 모델들이 등장했습니다.

최근에는 GPT와 BERT 같은 대규모 언어 모델이 트랜스포머(Transformer) 구조를 기반으로 개발되었습니다. 트랜스포머는 기존의 모델들과 달리 병렬 처리가 가능하며, 특히 자연어 처리(NLP) 분야에서 놀라운 성능을 보여주고 있습니다. 이 모델들은 대규모 데이터와 연산 자원을 활용하여 인간과 비슷한 수준의 언어 이해 및 생성 능력을 가지게 되었습니다.

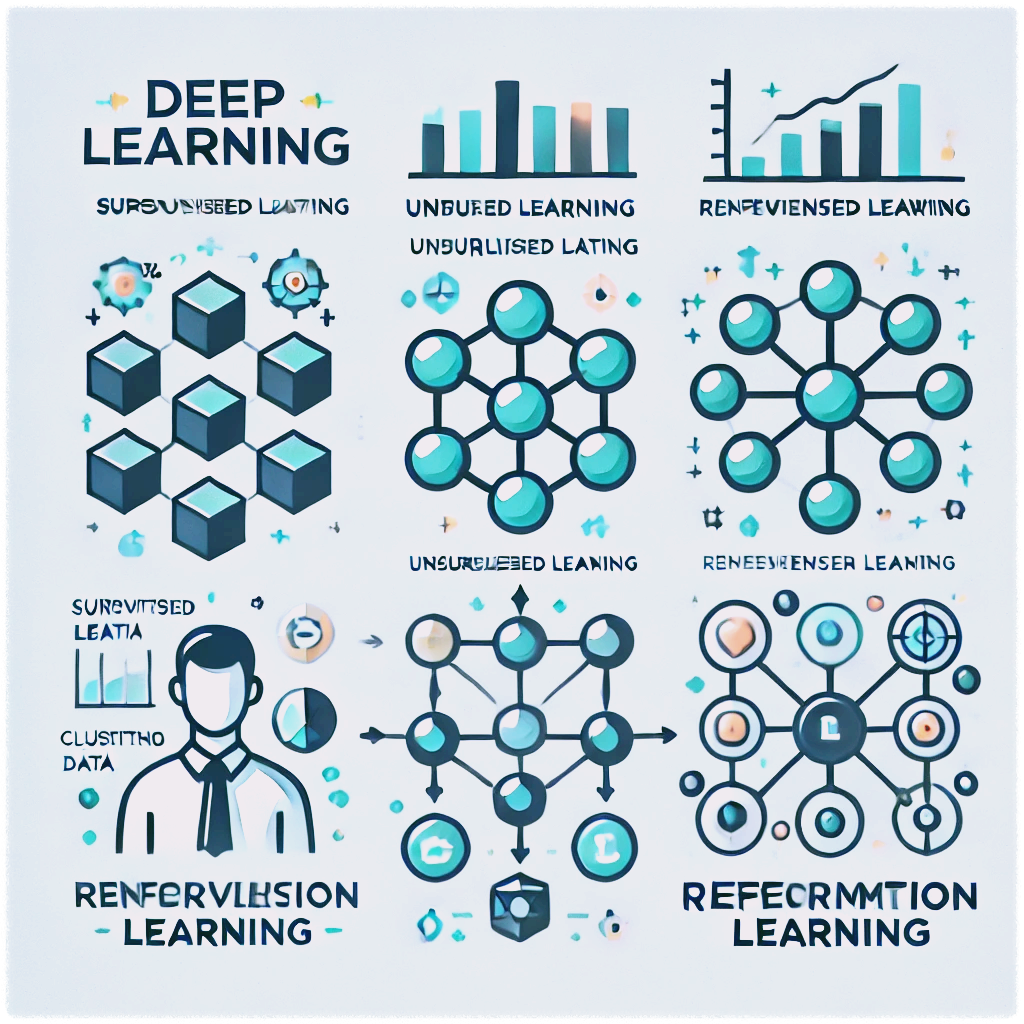

딥러닝의 학습 방식은 크게 세 가지로 구분됩니다. 지도 학습(Supervised Learning)은 정답이 있는 데이터를 기반으로 학습하며, 비지도 학습(Unsupervised Learning)은 정답 없이 데이터의 패턴을 발견하는 데 중점을 둡니다. 강화 학습(Reinforcement Learning)은 보상 시스템을 통해 최적의 행동을 학습합니다. 이러한 학습 방식은 이미지 데이터, 시퀀스 데이터(텍스트, 음성), 구조화된 데이터 등 다양한 데이터 형식에 따라 적용됩니다.

딥러닝 모델은 데이터를 통해 수많은 가중치(Weight)와 뉴런을 조정하며 패턴을 학습합니다. 발전 과정에서 모델이 해결할 수 있는 문제의 범위가 넓어지고, 점점 더 현실적인 응용 사례로 이어지고 있습니다. 이를 통해 딥러닝은 산업 전반과 우리의 일상에 중요한 영향을 미치고 있습니다.

2. 모델 학습의 기초: 다층 퍼셉트론부터 역전파까지

딥러닝 모델의 기초를 이해하기 위해서는 다층 퍼셉트론(Multi-Layer Perceptron, MLP)과 역전파(Backpropagation)의 작동 원리를 살펴보는 것이 중요합니다. 이 두 가지는 딥러닝 학습의 기본적인 원리와 과정을 이해하는 데 핵심적인 역할을 합니다.

다층 퍼셉트론(MLP)은 입력 데이터에서 시작해 은닉층(Hidden Layer)과 출력층(Output Layer)을 거치는 구조를 가지고 있습니다. 각 층에서 뉴런은 가중치(Weight)와 활성화 함수(Activation Function)를 통해 데이터를 처리하며, 이러한 과정을 통해 단순한 선형 문제뿐만 아니라 복잡한 비선형 문제도 해결할 수 있습니다. 특히 활성화 함수는 모델에 비선형성을 추가해 문제 해결 능력을 확장합니다.

딥러닝 모델이 데이터를 학습하기 위해 사용하는 최적화 알고리즘은 경사 하강법(Gradient Descent)입니다. 이 알고리즘은 손실 함수(Loss Function)의 값을 최소화하기 위해 가중치를 조정합니다. 손실 함수는 모델의 예측값과 실제값 사이의 차이를 측정하는 데 사용되며, 이를 기반으로 기울기(Gradient)를 계산해 가중치를 업데이트합니다.

학습 과정의 또 다른 중요한 원리는 역전파(Backpropagation)입니다. 역전파는 모델의 예측 오류를 계산하고, 이 오류를 신경망의 각 층으로 거꾸로 전파하여 가중치를 조정합니다. 이를 통해 모델은 반복적으로 학습하며 점점 더 정확한 예측을 할 수 있게 됩니다. 역전파는 딥러닝 모델의 학습을 가능하게 한 혁신적인 알고리즘으로, 현대 딥러닝 모델에서 필수적으로 사용됩니다.

딥러닝 학습 과정은 데이터를 반복적으로 모델에 제공하며, 손실을 줄여나가는 과정을 통해 이루어집니다. 이 과정에서 가중치와 편향(Bias)은 모델이 최적의 예측을 할 수 있도록 점진적으로 조정됩니다. 이러한 원리를 이해하면 딥러닝 모델이 데이터를 학습하고 일반화하는 방식을 더 깊이 이해할 수 있습니다.

3. 파이토치 기초 다지기: 텐서와 모델 구현

파이토치는 딥러닝 모델을 구현하고 학습시키기 위해 널리 사용되는 프레임워크입니다. 파이토치의 기본 단위는 텐서(Tensor)로, 이는 다차원 배열을 나타내며 딥러닝 모델의 모든 데이터를 처리하는 데 사용됩니다. 텐서를 이해하는 것은 파이토치를 사용하는 첫 번째 단계입니다.

텐서(Tensor)의 기본 개념

텐서는 수학적으로는 다차원 배열이며, 파이토치에서는 데이터를 저장하고 연산을 수행하는 핵심 데이터 구조입니다. 텐서는 1차원(벡터), 2차원(행렬), 혹은 더 높은 차원으로 표현될 수 있습니다. 예를 들어, 이미지는 3차원 텐서로, 비디오 데이터는 4차원 텐서로 표현됩니다.

import torch

# 1차원 텐서 생성

x = torch.tensor([1, 2, 3])

print(x)

# 2차원 텐서 생성

y = torch.tensor([[1, 2], [3, 4]])

print(y)

파이토치 모델 구조 이해

파이토치에서는 딥러닝 모델을 정의하기 위해 torch.nn.Module 클래스를 사용합니다. 이 클래스는 신경망의 계층을 정의하고, 데이터가 계층을 통해 흐르는 방식을 구현할 수 있게 합니다. 일반적으로 모델은 다음 두 가지 단계로 구성됩니다:

- 초기화 단계: 모델의 계층(layer)을 정의합니다.

- 순전파(forward pass): 입력 데이터가 모델의 계층을 거치며 출력 결과를 생성합니다.

예를 들어, 간단한 신경망 모델을 정의하는 코드는 다음과 같습니다:

import torch.nn as nn

class SimpleModel(nn.Module):

def __init__(self):

super(SimpleModel, self).__init__()

self.layer = nn.Linear(2, 1) # 입력 크기: 2, 출력 크기: 1

def forward(self, x):

return self.layer(x)

model = SimpleModel()

print(model)

텐서를 활용한 데이터 연산

파이토치의 텐서는 GPU를 활용한 빠른 연산을 지원합니다. 이를 통해 딥러닝 모델의 학습 속도를 크게 향상시킬 수 있습니다. GPU를 사용하려면 텐서를 장치(Device)로 이동시켜야 합니다:

# 텐서를 GPU로 이동

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

x = x.to(device)

print(x)파이토치의 텐서 연산은 기본적인 행렬 연산부터 복잡한 미분 계산까지 다양하게 지원합니다. 이를 통해 딥러닝 모델을 유연하게 설계하고 최적화할 수 있습니다.

4. 다양한 모델 구현: CNN과 RNN 실습하기

딥러닝 모델은 데이터를 분석하고 패턴을 학습하여 다양한 문제를 해결합니다. 이 중에서 CNN(합성곱 신경망)과 RNN(순환 신경망)은 각각 이미지와 시퀀스 데이터를 처리하는 데 특화된 모델입니다. 이 두 모델의 원리와 구현 방법을 알아보겠습니다.

CNN(합성곱 신경망)의 원리와 구현

CNN은 이미지 데이터를 처리하는 데 최적화된 신경망입니다. **필터(커널)**를 활용해 입력 이미지의 특징을 추출하며, 합성곱 연산과 풀링(pooling) 단계를 통해 데이터의 크기를 줄이고 중요한 패턴을 학습합니다.

CNN을 구현하는 간단한 코드는 다음과 같습니다:

import torch

import torch.nn as nn

class SimpleCNN(nn.Module):

def __init__(self):

super(SimpleCNN, self).__init__()

self.conv1 = nn.Conv2d(1, 16, kernel_size=3, stride=1, padding=1) # 입력 채널 1, 출력 채널 16

self.pool = nn.MaxPool2d(kernel_size=2, stride=2)

self.fc1 = nn.Linear(16 * 14 * 14, 10) # fully connected layer

def forward(self, x):

x = self.pool(torch.relu(self.conv1(x)))

x = x.view(-1, 16 * 14 * 14) # Flatten

x = self.fc1(x)

return x

model = SimpleCNN()

print(model)

위 코드는 단순한 CNN을 정의하며, 필터를 사용해 특징을 추출한 후 완전 연결 계층(fully connected layer)으로 분류를 수행합니다.

RNN(순환 신경망)의 원리와 구현

RNN은 시퀀스 데이터를 처리하는 데 특화된 신경망입니다. RNN은 시간 순서에 따라 데이터를 처리하며, 이전 상태를 반영하는 은닉 상태(hidden state)를 사용해 연속된 데이터를 학습합니다.

RNN을 구현하는 간단한 코드는 다음과 같습니다:

class SimpleRNN(nn.Module):

def __init__(self, input_size, hidden_size, output_size):

super(SimpleRNN, self).__init__()

self.rnn = nn.RNN(input_size, hidden_size, batch_first=True)

self.fc = nn.Linear(hidden_size, output_size)

def forward(self, x):

out, _ = self.rnn(x)

out = self.fc(out[:, -1, :]) # 마지막 시점의 출력 사용

return out

model = SimpleRNN(input_size=10, hidden_size=20, output_size=1)

print(model)

이 코드는 단순한 RNN을 정의하며, 입력 데이터의 시퀀스를 처리한 후 마지막 출력값을 기반으로 결과를 예측합니다.

CNN과 RNN을 구현하면서 느낀 점은 두 모델이 각기 다른 데이터 특성에 최적화되어 있다는 점입니다. CNN은 이미지 데이터에서 중요한 공간적 정보를 학습하는 데 매우 효과적이었고, RNN은 텍스트와 같은 시퀀스 데이터의 시간적 흐름을 이해하는 데 강력했습니다. 하지만, RNN의 경우 긴 시퀀스를 처리할 때 정보가 소실되는 문제가 있었고, 이를 개선하기 위해 LSTM(Long Short-Term Memory)과 GRU(Gated Recurrent Unit)와 같은 확장된 모델이 필요하다는 점도 알게 되었습니다.

5. 모델 성능 높이기: 고도화 전략과 전이 학습

딥러닝 모델의 성능을 높이는 것은 모델 학습의 핵심 과제 중 하나입니다. 이를 위해 다양한 고도화 전략과 전이 학습(Transfer Learning) 기법이 활용됩니다. 이러한 방법들은 모델의 정확도를 높이고 과적합을 방지하며, 새로운 데이터셋에서 효율적으로 학습할 수 있도록 돕습니다.

고도화 전략

- 과적합 방지

- 과적합은 모델이 학습 데이터에는 잘 맞지만, 새로운 데이터에는 일반화하지 못하는 문제를 의미합니다. 이를 방지하기 위해 Dropout이나 정규화(Regularization) 기법이 사용됩니다.

# Dropout 사용 예시 self.dropout = nn.Dropout(p=0.5) - 학습률 조정

- 학습률(Learning Rate)은 모델의 학습 속도를 조정하는 중요한 하이퍼파라미터입니다. Learning Rate Scheduler를 사용하면 학습 중 학습률을 점진적으로 줄여 성능을 최적화할 수 있습니다.

from torch.optim.lr_scheduler import StepLR scheduler = StepLR(optimizer, step_size=10, gamma=0.1) - 데이터 증강(Data Augmentation)

- 데이터 증강은 기존 데이터를 변형하여 새로운 데이터를 생성하는 기법입니다. 이는 데이터의 다양성을 높여 과적합을 줄이는 데 도움을 줍니다.

from torchvision import transforms transform = transforms.Compose([ transforms.RandomHorizontalFlip(), transforms.RandomRotation(10), ])

전이 학습(Transfer Learning)

전이 학습은 사전에 학습된 모델을 새로운 문제에 재활용하는 기법입니다. 대표적인 전이 학습 모델로는 ResNet과 EfficientNet이 있으며, 이를 사용하면 학습 데이터를 효과적으로 활용할 수 있습니다.

1. 사전 학습된 모델 불러오기

from torchvision import models

model = models.resnet50(pretrained=True)

2. 기존 모델의 일부 계층 고정

- 사전 학습된 모델의 일부 계층을 고정(freeze)하여 새로운 데이터셋에 맞는 출력 계층만 학습시킬 수 있습니다.

for param in model.parameters():

param.requires_grad = False

3. 새로운 데이터셋에 맞는 모델 수정

model.fc = nn.Linear(model.fc.in_features, num_classes)

딥러닝 모델의 성능을 높이기 위한 다양한 전략을 학습하면서, 모델의 성능은 단순히 더 많은 데이터를 학습시키는 것이 아니라, 데이터를 효율적으로 활용하고 학습 과정을 최적화하는 데 달려 있다는 것을 깨달았습니다. 특히 전이 학습을 통해 적은 데이터로도 뛰어난 결과를 얻을 수 있다는 점이 매우 인상적이었습니다. 또한, 하이퍼파라미터 튜닝과 학습률 조정의 중요성을 실감하며, 딥러닝 모델의 세부적인 설계와 조정이 얼마나 중요한지 느꼈습니다.

요약 및 앞으로의 계획

딥러닝과 파이토치를 학습하며, 저는 단순한 기술적 지식 이상의 많은 것을 배웠습니다. 처음에는 딥러닝의 기본 개념과 파이토치의 구조조차 이해하기 어려웠지만, 작은 단계부터 시작하여 점차 복잡한 모델까지 구현할 수 있게 되었습니다. 이 과정에서 제가 가장 크게 느낀 점은 딥러닝은 단순히 코드를 작성하는 것이 아니라, 데이터를 이해하고, 문제를 정의하며, 최적의 결과를 도출하는 창의적이고 논리적인 과정이라는 점입니다.

CNN과 RNN 같은 모델을 구현하면서, 데이터의 특성에 따라 적합한 모델을 선택하는 것이 얼마나 중요한지 배웠습니다. 또한, 고도화 전략과 전이 학습을 통해 적은 리소스로도 효과적인 결과를 얻을 수 있다는 점에서, 딥러닝의 가능성과 효율성에 다시 한번 놀라게 되었습니다.

이 학습 여정을 통해 저는 다음과 같은 깨달음을 얻었습니다:

- 딥러닝 학습은 끝없는 여정이다.

- 새로운 기술과 도구가 계속해서 등장하기 때문에, 끊임없이 배우고 실험하는 자세가 필요합니다.

- 이론과 실습은 균형을 이루어야 한다.

- 이론적인 이해가 뒷받침되지 않으면 실습에서 오류를 해결하기 어렵고, 실습을 병행하지 않으면 이론이 현실적으로 와닿지 않습니다.

- 작은 성공이 자신감을 키운다.

- 간단한 모델을 처음 학습시키고 성공했을 때의 성취감은 더 큰 도전을 할 수 있는 동력이 되었습니다.

앞으로는 이번에 배운 지식과 기술을 바탕으로 더 복잡한 프로젝트에 도전하고 싶습니다. 특히, 실제 데이터를 활용하여 사회적 가치를 창출할 수 있는 모델을 만들어보고 싶습니다. 예를 들어, 의료 진단을 위한 이미지 분석 모델이나 자연어 처리를 활용한 언어 번역 모델과 같은 프로젝트를 구상하고 있습니다.

딥러닝은 여전히 많은 가능성을 품고 있는 분야입니다. 저의 학습 경험이 비슷한 여정을 시작하려는 분들에게 작은 동기와 도움이 되었기를 바랍니다. 앞으로도 꾸준히 배우고 성장하며 새로운 도전을 이어나가겠습니다.

'YES - 개발일지' 카테고리의 다른 글

| [Upstage AI Lab 5기 부트캠프] NLP 경진대회 (1) | 2025.02.02 |

|---|---|

| [Upstage AI Lab 5기 부트캠프] 문서 타입 분류 CV 경진대회에서 1위 도전 (1) | 2025.01.02 |

| [Upstage AI Lab 5기 부트캠프] MLOps 프로젝트 — 영화추천시스템 (2) | 2024.12.09 |

| [Upstage AI Lab 5기 부트캠프] 첫번째 피어세션 (0) | 2024.11.23 |

| '서울시 아파트 가격 예측' 경진대회 ─ Upstage AI Lab 5 (2) | 2024.11.15 |

댓글